Что такое A/B-тестирование и как его проводить в Google Optimize

Первоичточник статьи: блог iConText Group. Автор: Станислав Киров, руководитель группы web-аналитиков в iConText Group.

Что такое A/B-тестирование

Для этого проводим тест и создаем второй вариант страницы: вариант А будет с черной кнопкой, вариант В — новый, с цветной кнопкой. А затем запускаем тест.

Пользователи, которые приходят на страницы, делятся в пропорции 50 на 50:

- 50% видят вариант А, с черной кнопкой;

- 50% видят вариант B, с цветной кнопкой.

Зачем проводить А/B-тесты

И тут дело может быть не в том, что рекламные кампании приводят нецелевой трафик. Зачастую проблемы кроются на самом сайте. Клиенты могут уходить на разных этапах воронки из-за нарушенной логики взаимодействия или непонятного интерфейса. A/B-тестирование помогает справиться с этими проблемами.

Что можно тестировать

- Текст (например, заголовок и описание продукта).

- Внешний вид конверсионных кнопок или их расположение.

- Размеры, внешний вид и расположение конверсионных форм.

- Макет и дизайн страницы.

- УТП (цена, изображение товаров, характеристики и т. п.).

Как проводить A/B-тест

Первым делом проводим исследование на сайте. Делая UX-аудит, аналитик руководствуется общими правилами и субъективным мнением об удобстве ресурса. Но что удобно аналитику, не обязательно будет удобно всем пользователям сайта. Для исключения субъективного фактора и проводят A/B-тесты.

Шаг 2. Формирование гипотез

На этом этапе мы выдвигаем гипотезы. Например, что такие-то изменения на сайте могут улучшить показатель. Но могут и не улучшить, а наоборот — ухудшить. Это как раз и покажет A/B-тест.

Шаг 3. Создание вариантов

Создаем разные варианты и тестируем: А — старый вариант, В — новый.

Шаг 4. Запуск теста

Далее мы запускаем тест. Так как гипотеза может не сработать и ухудшить показатели, проводим тест не на всем трафике, а только на части, например на 10% пользователей. Этим 10% пользователей показываем в соотношении 50/50 два разных варианта.

Допустим, в день на сайт заходят 1000 человек. В случайном порядке мы отбираем только 10% для теста, т. е. 100 пользователей, а затем делим их на две группы пополам: 50 пользователей видят вариант А, а остальные 50 пользователей видят вариант В.

В случае негативного развития событий это позволит не просесть в конверсии в целом.

Шаг 5. Анализ результатов

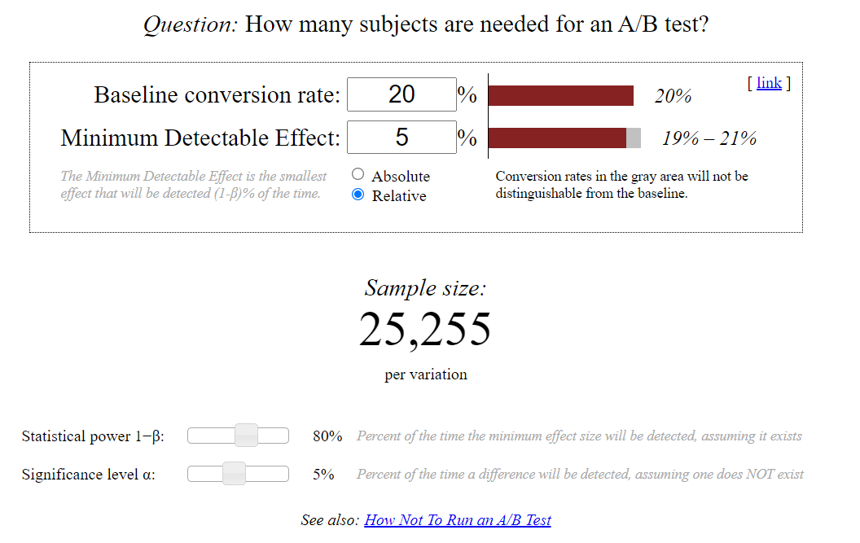

Время проведения теста и количество пользователей в двух выборках рассчитывается до запуска теста. После того, как пройдет заданное время и в двух выборках наберется достаточное число посетителей, мы собираем статистику и анализируем результаты.

Шаг 6. Рекомендации по итогам теста

Если гипотеза подтвердится и победит вариант с внесенными изменениями, то мы пишем рекомендации по их внедрению на сайт.

Что нужно для запуска А/B-теста

- Так как тест проводится через GoogleOptimize , то сначала надо создать аккаунт в Google Optimize. Обычно один аккаунт для одного клиента.

- Создаем контейнер в аккаунте Google Optimize. На этом уровне определяется связь с веб-сайтом. Один сайт = один контейнер Google Optimize.

- Размещаем код контейнера Google Optimize на сайте (через GTM или напрямую в код сайта).

- Делаем все необходимые настройки теста в Google Optimize.

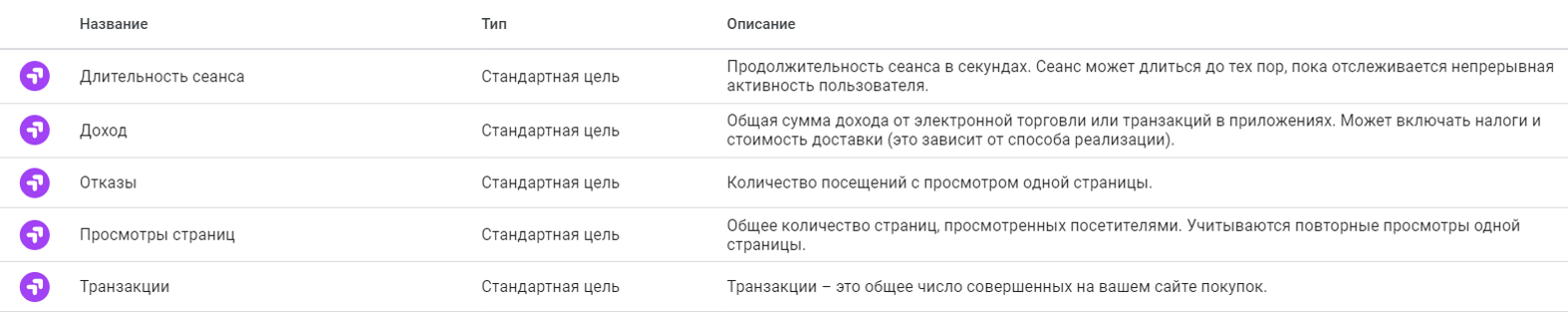

Выбор/создание целевых показателей

Помимо предустановленных целевых показателей, можно использовать цели из Google Analytics. Например, если нужно отследить клик по кнопке, то настраиваем в Google Analytics специальную цель, которая будет это фиксировать, и уже потом в Google Optimize выбираем ее.

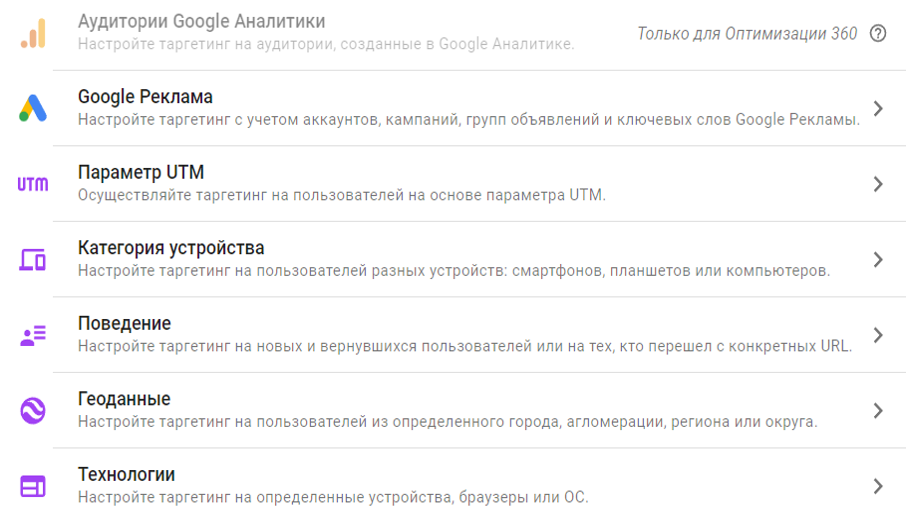

Выбор/создание целевой аудитории

Это очень важно, потому что посетители, которые уже взаимодействовали с сайтом, могут пугаться новинок: новых лендингов, интерфейсов. Им будет сложно сориентироваться, где и что находится. Как следствие, показатель отказов может увеличиться.

Поэтому перед запуском нужно подумать, на какую аудиторию запускать тест. Возможно, лучше ориентироваться на новых пользователей, которые до этого не взаимодействовали с сайтом.

Также можно таргетироваться по геоданным (например, настроить тест на определенный регион), браузерам и операционным системам.

Если версия Google Analytics 360 платная, то вам будет доступен Google Optimize 360. Благодаря этому вы сможете дополнительно таргетироваться на аудитории, созданные в Google Analytics.

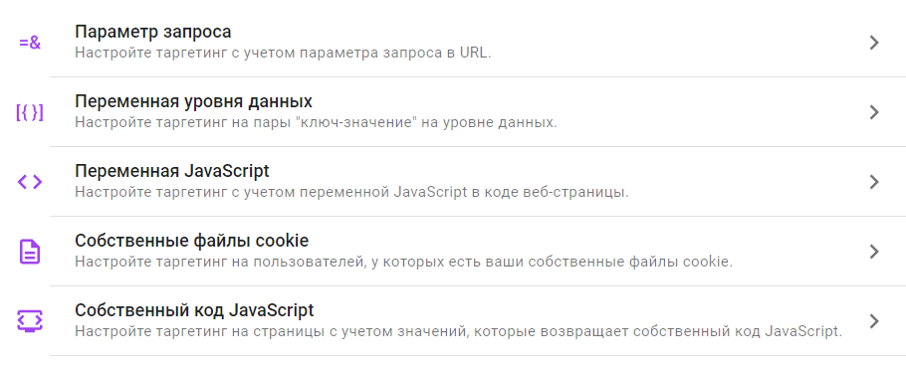

Помимо прочего, можно сегментировать пользователей по параметрам запроса в URL, различных переменных в уровне данных, переменных JavaScript, собственным файлам cookie и коду JavaScript. Это уже некоторые технические моменты, которые обсуждаются с программистом на стороне сайта, по какому принципу и как будет отбираться аудитория для теста.

Что такое А/А-тест и зачем он нужен

- на результаты не влияют аномалии и выбросы в генеральной совокупности;

- инструмент «деления» трафика работает безошибочно;

- данные отправляются в системы аналитики корректно.

У нас в практике был случай. На сайте висела форма заказа, где нужно было вводить дату рождения. В форме был баг: в поле невозможно было ввести дату рождения, если пользователь младше 21 года, а на страницу в том числе приходили люди в возрасте от 18 до 21 года. Они не могли заполнить форму. Как следствие, показатель отказов увеличился.

В ходе теста мы заметили, что конверсия между вариантами А и B различается в 2-3 раза. Чтобы понять, почему так происходит, мы посмотрели Вебвизор. В итоге выявили баг, который очень сильно повлиял на итоговый результат. Пришлось переделывать тест. Но вот если бы мы изначально на этом лендинге провели A/A-тест, мы бы обнаружили баг заранее: у одной из групп конверсия бы сильно отличалась.

Сколько нужно трафика и времени на тест

Минимальная длительность теста

Возможные причины всплесков:

- будни или выходные;

- праздники (увеличение спроса на «подарочные» товары);

- распродажи, акции, маркетинговые активности (скидки увеличивают активность аудитории, меняя покупательское поведение);

- особые события (например, покупки товаров для школы в августе);

- сезонность продукта (например, обогреватели);

- деятельность конкурентов (конкуренты снизили цены на продукт, и активность ваших пользователей уменьшилась);

- изменение в политической и экономической обстановке (кризис, рост цен, запрет на торговлю товаром, увеличение его стоимости из-за дополнительных пошлин).

Или, например, ваш клиент — магазин детских игрушек, и вы хотите приступить к тесту гипотезы. Вы рассчитали в онлайн-калькуляторе, что длительность теста 4 недели, а сейчас, допустим, 15 декабря. Лучшим решением будет отложить запуск теста на конец января, потому что в новогодние праздники покупательская активность сильно меняется (если запустить тест 15 декабря, и он будет длиться 4 недели, то новогодние праздники точно захватим). Все подтвержденные гипотезы могут показать совсем другие результаты, например, весной, когда покупательское поведение изменится.

Помимо всплесков активности, следует понимать цикл реализации измеряемой метрики. Чаще всего он связан с циклом принятия решения о покупке — временем, прошедшим от первой мысли о приобретении товара до оформления заказа. Сами понимаете, что цикл принятия решения о покупки квартиры намного больше, чем у покупки товара в интернет-магазине.

Интерпретация результатов

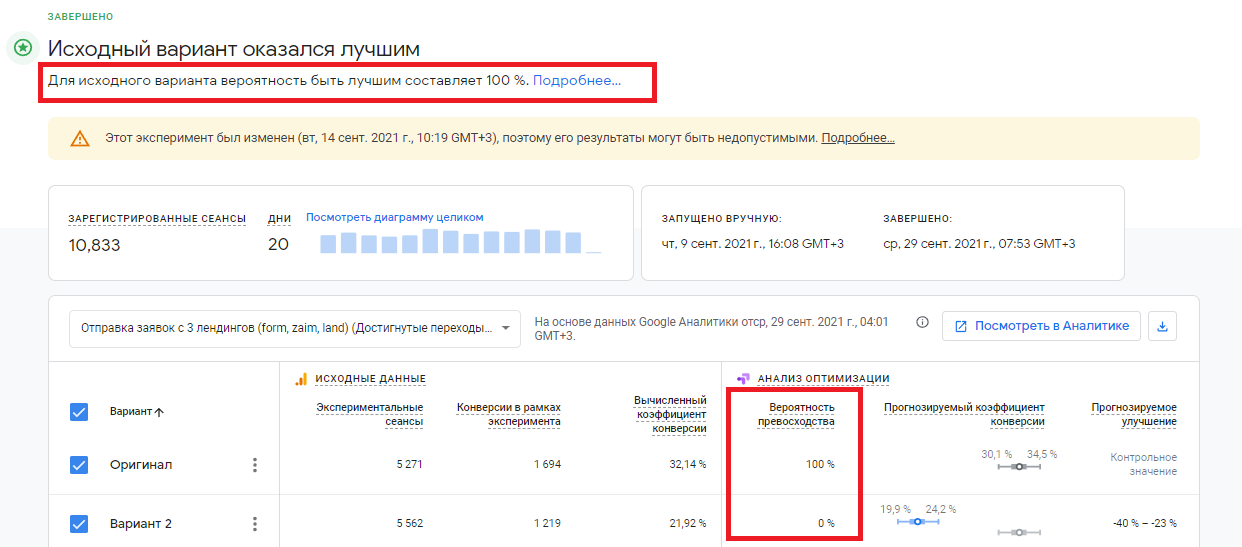

Вероятность превосходства

В нашем примере исходный вариант оказался лучше.

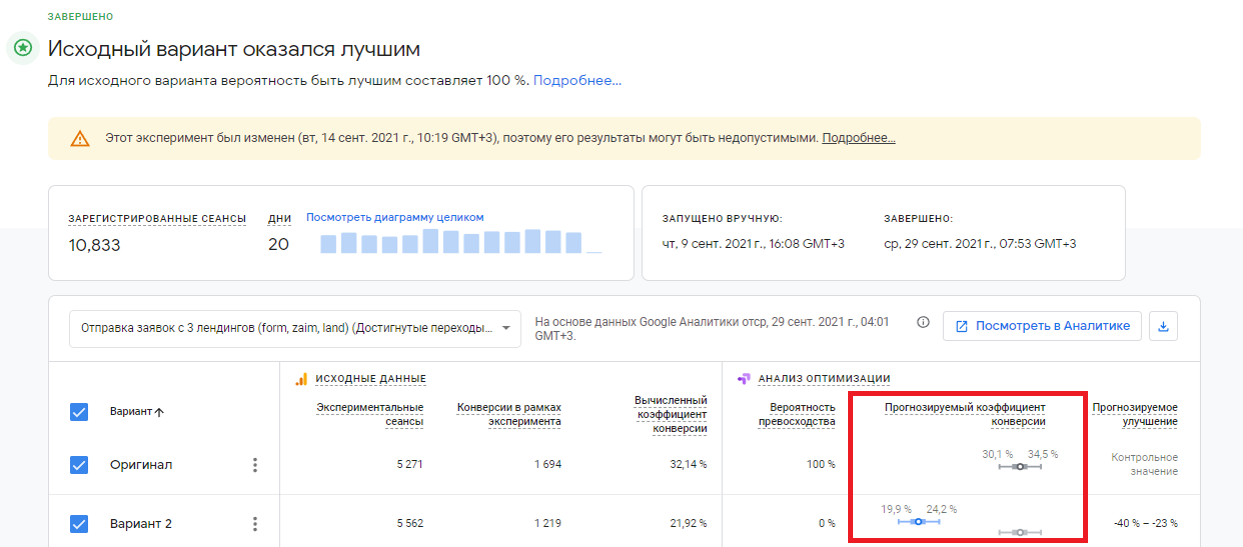

Прогнозируемый коэффициент конверсии

При подсчете данного показателя учитываются только те сеансы, которые участвовали в тесте, а также связанные с ними конверсии.

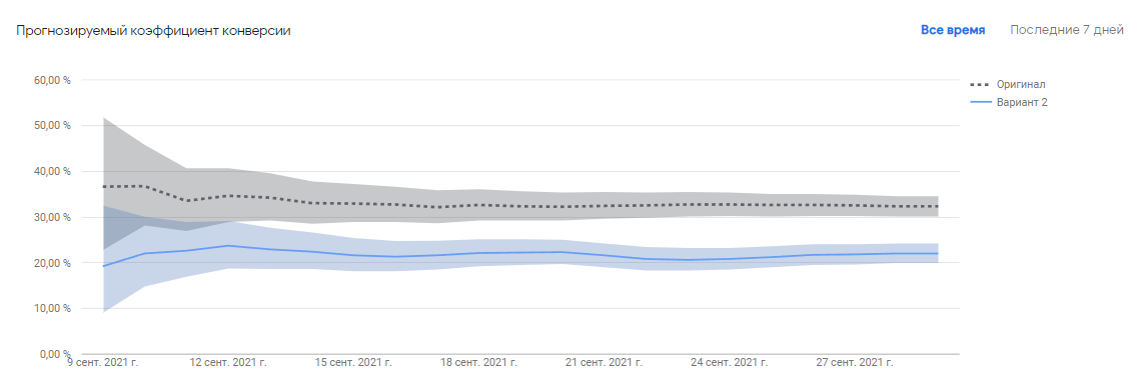

Изучив графики кумулятивных, или накапливаемых данных, можно увидеть следующую картину. Например, тест длился 14 дней. Если построить график по кумулятивным данным, в точке первого дня будут значения метрик за этот день, в точке второго дня — набор метрик за два дня, в точке третьего — набор за три.

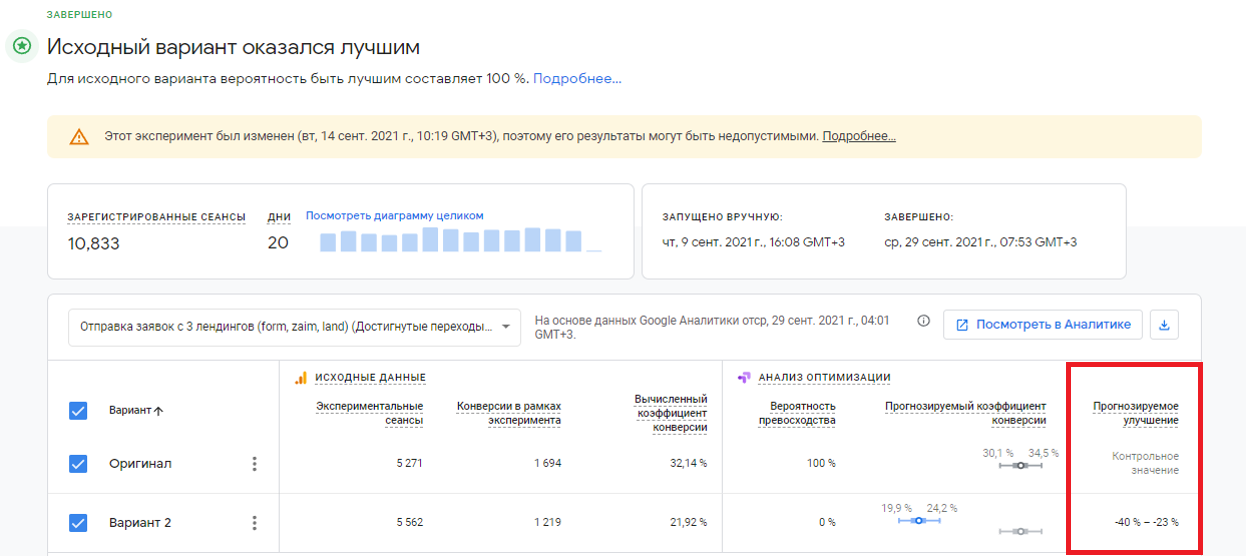

Прогнозируемое улучшение

Результат A/B-теста

Да, такое бывает, что предложенный вариант не срабатывает и ухудшает показатели. Напоминаю, что тест проводится не на 100% трафике сайта, а только на его небольшой части, поэтому такой показатель варианта 2 не сильно сказался на итоговой конверсии.

Таким образом, A/B-тестирование помогает точно измерить эффект от реализованного изменения. Поэтому даже если гипотеза не подтвердилась, не стоит отчаиваться. Просто тестируйте новые варианты, чтобы улучшить целевые показатели.