AI против медиа: новая экономика трафика и кликов

ИИ с удовольствием читает ваш экспертный контент. Не скажет ли он вам за это спасибо?

Вы создаёте свежий, продуманный, полезный материал и нажимаете «опубликовать». Но первым его «читателем» оказывается вовсе не человек, а бот. И не один.

Раньше всё было понятно: YandexBot и GoogleBot индексировали, приводили трафик, помогали расти. Сегодня же у паблишеров целый букет из ботов: GPTBot (ChatGPT, созданный американской компанией OpenAI), Google-Extended (нейросеть Gemini от американской Google), ClaudeBot (модель Claude от американской Anthropic), DeepSeekBot (китайская нейросеть DeepSeek) и десятки других. Их цель — не привести пользователя на сайт, а ответить за него.

Одни паблишеры надеются попасть в рекомендации AI-ассистентов и получить новую видимость. Другие всё чаще говорят: «AI просто съедает наш контент». И это ощущение небезосновательно.

Но действительно ли у паблишеров нет шансов или мы наблюдаем очередной переломный момент, где выживут те, кто быстрее адаптируется? В этой статье специалисты Digital Caramel попробуют разобраться в вопросе.

От поисковых ботов к AI-экосистемам

Всего несколько лет назад краулеры были посредниками. Они индексировали страницы и возвращали пользователя на сайт. AI-краулеры играют по другим правилам: они забирают информацию, обобщают её и оставляют пользователя внутри своей экосистемы.

Исследования показывают, что сегодня AI-боты занимают заметную долю всего crawl-трафика. Иногда — критичную.

Показательный кейс — недавняя история с open-source-платформой Read the Docs. После того как сайт заблокировал AI-ботов, ежедневный объём трафика снизился примерно с 800 ГБ до 200 ГБ. То есть минус 75% нагрузки и около $1500 экономии в месяц. Это наглядно показывает: значительная часть запросов идёт вовсе не от живых пользователей.

С одной стороны, доступ AI-краулеров даёт шанс появиться в ответах ChatGPT, Perplexity или AI-поиске. С другой, они:

- создают серьёзную нагрузку на серверы;

- не кликают;

- не покупают;

- не монетизируются;

- и всё чаще заменяют сам переход на сайт готовым ответом.

Неудивительно, что всё больше паблишеров тянутся к кнопке block.

«AI-ловушка»: когда видимость есть, а кликов нет

Главная проблема заключается не в самом факте сканирования контента. Проблема в том, что происходит после.

AI-сводки в поиске («Поиск с Алисой», AI Overviews и аналоги) отвечают пользователю прямо в выдаче, используя материалы паблишеров как сырьё. Пользователь получает готовый ответ и на сайт просто не заходит.

AI не пытается навредить. Но его логика разрушительна по своей природе:

удерживать пользователя внутри собственной платформы.

SEO стремительно меняется. Мы уходим от гонки позиций к эпохе «кормления LLM-моделей». Если раньше поисковик ещё делился трафиком, то теперь он всё чаще становится конечной точкой. Для паблишера это означает болезненный парадокс: позиции и импрессии сохраняются, а CTR падает.

Цифры подтверждают тренд.

-

Semrush: AI Overviews показываются более чем в 13% запросов, сильнее всего ударяя по информационному контенту.

-

The Guardian: некоторые новостные сайты теряют до 80% CTR, если их ссылка оказывается под AI-сводкой.

-

Reuters: независимые издатели в Европе уже подали антимонопольные жалобы на Google.

На практике это выглядит так:

-

брендовые запросы почти не страдают;

-

топ-1 начинает вести себя как бывшие позиции 6–10;

-

информационные запросы резко падают.

Если раньше CTR топ-1 был 28–40%, то сегодня он часто опускается до 10–22%. Это уже не исключения, а системный сдвиг.

|

|

Рач Хумалян

СЕО Digital Caramel |

«Проблема заключается не столько в самих AI-ботах, сколько в структурной трансформации экономики клика. Если ранее поисковые системы выступали посредником между пользователем и сайтом, то сегодня они все чаще становятся конечной точкой взаимодействия. AI-ответы лишь логично завершают этот сдвиг, концентрируя потребление контента внутри экосистемы поисковика. Для паблишеров это создаёт болезненный эффект: видимость и позиции в поиске сохраняются, но кликабельность снижается. В результате падает объём просмотров, ухудшается заполняемость рекламного инвентаря, снижается эффективный CPM на информационных страницах и, как следствие, общая монетизация.

При этом сегменты, связанные с уникальными данными, инструментами, аналитикой, практическим опытом и экспертизой, демонстрируют значительно большую устойчивость. Это подтверждается как поведением аудитории, так и финансовыми показателями. Пользователи по-прежнему готовы переходить туда, где поисковик или AI не могут заменить ценность первоисточника, а бизнес-модель таких продуктов оказывается менее зависимой от классической поисковой дистрибуции».

Контент, который AI «съедает» первым

Сильнее всего страдают форматы, которые легко упростить до одного абзаца.

1. Простые how-to и определения

Форматы вроде «Как настроить Алису», «Симптомы гриппа», «Что такое ROI» — всё, что можно свести к короткому абзацу или списку — AI легко перехватывает и выдаёт пользователю самостоятельно.

2. Шаблонные обзоры и affiliate-топы

Материалы уровня «Лучший VPN» или «10 лучших рекламных сетей…» — классический пример контента, который AI может сравнить и структурировать самостоятельно.

3. Коммодитизированные новости

AI-резюме почти идеально пересказывает стандартные новости вроде анонсов обновлений, функций, слухов или оперативных данных (например, криптокурсов). В связке с разделом Яндекс Новости пользователю, чтобы получить всю информацию, часто достаточно одного взгляда.

4. Простые рецепты

Запросы вроде «Как приготовить борщ» уже хорошо закрываются Яндексом: ингредиенты, шаги, изображения — всё доступно прямо в выдаче.

Где AI пока не выигрывает

И вот здесь начинаются хорошие новости. AI по-прежнему критически зависит от источников, которые он не способен заменить.

1. Оригинальная аналитика и исследования

Сохраняет нужные нам клики всё, что невозможно «синтезировать»: бенчмарки, кейсы, исследования, обзоры, эксперименты, собственные инсайты и данные.

Пример исследования Digital Caramel и Mobidriven на Cossa

2. Собственные базы данных

Практически не заменимы каталоги, индексы, таблицы, которые вы собираете сами.

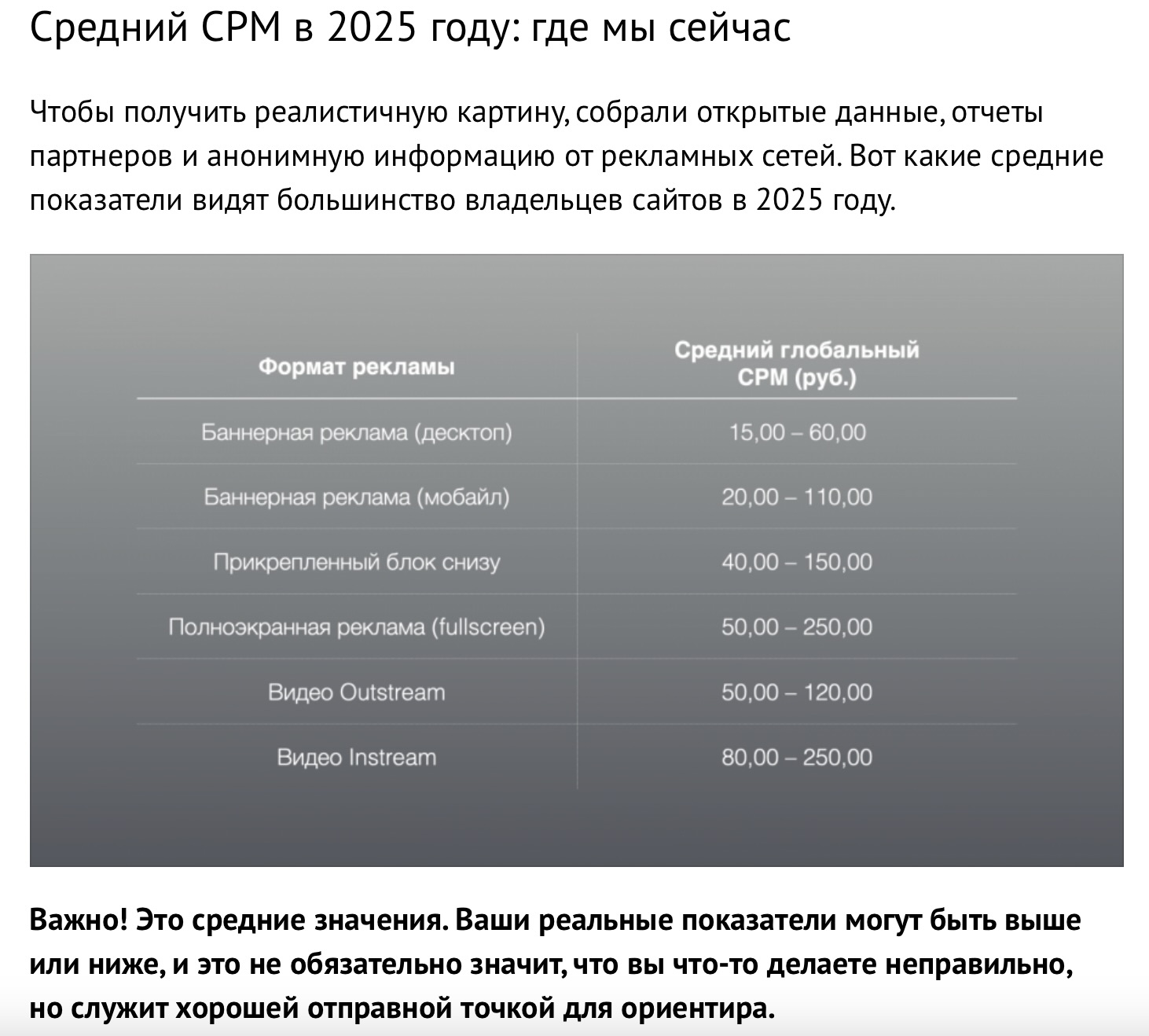

Таблица из статьи Digital Caramel «Какой CPM считается хорошим в 2025 году? Честный разбор» на Sostav

3. Мультимедиа

В AI-сводку плохо укладываются видео, схемы, скриншоты и визуальные данные. Такие материалы остаются ценным трафиковым активом.

4. Экспертный и личный опыт

AI не проживал ваш путь, не ошибался и не принимал решений. Лучше всего работают форматы «что пошло не так», AMA-сессии, разборы реальных бюджетов.

Пример статьи Digital Caramel в Т-Бизнес секретах

5. Интерактивные инструменты

Это один из самых «будущеустойчивых» форматов:

- калькуляторы;

- визуализаторы;

- подборщики и селекторы продуктов;

- прогнозные модели.

Такие страницы решают конкретные задачи пользователя и создают повод возвращаться.

6. Ясная, смелая позиция

AI стремится к нейтральности. Сильным преимуществом остаётся чёткое, аргументированное мнение.

Пример экспертного комментария из статьи Digital Caramel «Тренды диджитал-рынка 2026: 15 тенденций развития онлайна» на Sostav

|

|

Диана Алейникова

Коммерческий директор Digital Caramel |

«С точки зрения коммерции для паблишера сегодня критичны три направления.

Во-первых, жёсткий контроль качества трафика. Любые аномальные источники, создающие нагрузку без участия в монетизации, представляют собой прямые потери и должны не просто фиксироваться, а системно отсекаться.

Во-вторых, переход от масштабирования контента к развитию продуктовых форматов: интерактивных инструментов, собственных данных, аналитики, кейсов и экспертизы. Всё, что невозможно свести к одному абзацу AI-ответа, сохраняет клики и остаётся ценным для рекламодателя.

В-третьих, корректно выстроенная рекламная стратегия. В условиях снижения CTR из-за AI-блоков каждая оставшаяся сессия должна монетизироваться максимально эффективно — за счёт форматов, частоты, viewability и прозрачной аналитики. Именно здесь ключевую роль начинают играть programmatic-подход и контроль показов.

AI не уничтожает рынок паблишеров. Он ускоряет отказ от устаревших моделей монетизации. Те, кто адаптируется к этим изменениям уже сейчас, в перспективе получат более устойчивый и прогнозируемый доход».

Блокировать ли AI-краулеров?

SEO это не убьёт.

Ранжирование Яндекса зависит только от его ботов (YandexBot, YandexImages и другие). Блокировка GPTBot, ClaudeBot или других AI-сканеров напрямую не влияет на позиции.

Но существуют косвенные риски. Если AI-платформы не видят ваш контент, вы лишаетесь:

-

присутствия в AI-ответах;

-

шансов попасть в AI-поисковые интерфейсы;

-

видимости внутри Perplexity, Bing + ChatGPT, SGE и других ассистентов.

Это может оказаться чувствительной потерей, если ваш сайт живёт за счёт новостей, обзоров и инструкций.

Причины, по которым паблишеры всё-таки не хотят никаких краулеров:

-

превращение контента в ресурс для конкурирующих сервисов;

-

неконтролируемое и непрозрачное использование материалов;

-

юридические и лицензионные ограничения;

-

рост затрат на инфраструктуру и серверные ресурсы;

-

потеря контроля над контекстом, авторством и качеством интерпретации;

-

размывание бренда и усиление вторичного контента, конкурирующего с первоисточником.

В результате блокировка GPTBot, ClaudeBot, CCBot и других AI-краулеров становится для многих паблишеров не жестом конфронтации, а инструментом защиты: контента, бренда, инфраструктуры и собственной бизнес-модели.

Как выстроить грамотную защиту от AI-краулеров

Копировать чужой robots.txt — плохая идея. Универсального шаблона не существует: у каждого сайта своя нагрузка, своя модель монетизации и свои риски. Поэтому вместо формального запрета важно выстроить осознанную политику доступа.

К тому же рассчитывать только на robots.txt уже наивно. Значительная часть AI-краулеров либо частично его игнорирует, либо маскируется под обычный пользовательский трафик. В реальности эффективная защита всегда должна быть многоуровневой.

Как правило, она включает:

-

ограничения и правила на уровне сервера (Nginx, .htaccess);

-

инструменты вроде Cloudflare Bot Management;

-

лимиты на частоту запросов;

-

фильтрацию трафика через WAF;

-

блокировку известных дата-центров и ASN;

-

постоянный анализ и аудит логов.

CAPTCHA больше не является надёжным барьером. Современные AI-агенты способны имитировать поведение реального пользователя и обходить даже продвинутые решения вроде Turnstile. Поэтому защита должна строиться не вокруг одного инструмента, а вокруг системы.

Эта система опирается на:

-

чётко сформулированные правила доступа;

-

блокировки на edge-уровне;

-

регулярный пересмотр и корректировку фильтров.

Особое внимание стоит уделять мониторингу аномалий, в том числе:

-

большому объёму сессий без какой-либо монетизации;

-

резким всплескам трафика без роста доходов;

-

подозрительным IP-диапазонам и нестандартным паттернам поведения.

При этом сами по себе AI-краулеры не являются «злом». Их влияние неоднозначно:

-

они подрывают эффективность простых информационных страниц;

-

в меньшей степени, но всё же снижают отдачу от коммерческого и экспертного контента;

-

заставляют пересматривать подходы к индексированию и дистрибуции;

-

повышают ценность контента и продуктов, которые невозможно свести к короткому AI-ответу.

На практике наиболее устойчивая стратегия сегодня выглядит так:

-

системно отсекать бесполезный и затратный бот-трафик;

-

инвестировать в форматы, которые нельзя легко упростить или воспроизвести в AI-сводке;

-

работать над максимальной ценностью каждой сессии живого пользователя.

|

|

Татьяна Филина

Менеджер по коммуникациям Digital Caramel |

«Стратегия работы с AI-краулерами не должна быть бинарной. Речь не идёт о простом выборе „пускать или блокировать всех“. Гораздо эффективнее рассматривать ботов с точки зрения их ценности и реального вклада в бизнес: какие из них создают хотя бы косвенную пользу, а какие формируют исключительно нагрузку и риски. Любые решения о блокировке должны приниматься на основе метрик: влияния на серверную нагрузку, скорости сайта, качества трафика и его вклада в доход. В условиях быстро меняющейся AI-экосистемы политика доступа требует регулярного пересмотра и корректировки, а не разовой настройки».

Важный момент: даже качественный трафик не принесёт результата без корректной монетизации. В условиях падения CTR из-за AI-блоков важно, чтобы рекламные форматы, частота показов и аналитика были настроены максимально точно. Стабильный доход — лучший индикатор того, что сайт выходит из «AI-ловушки» и остаётся востребованным у реальной аудитории.

Так кто кого?

Пока AI выигрывает тактически, но стратегически без паблишеров он проиграет.

Если исчезнет мотивация создавать качественный контент, модели начнут обучаться на вторичных пересказах, деградируя. «Контентная инфляция» — реальная угроза для ИИ.

Паблишеры же стоят перед выбором: бороться за старую модель или переизобрести свою роль в мире, где информация больше не дефицит, а доверие и экспертиза — да.

Мнение редакции может не совпадать с мнением автора. Ваши статьи присылайте нам на 42@cossa.ru. А наши требования к ним — вот тут.