Внедрить ИИ без проблем с законом: руководство для компаний

Как работать с ИИ, которому по определению не знакома человеческая этика.

Человечество встретило генеративный ИИ с ажиотажем и быстро сформировало завышенные ожидания. С каждым годом доверие к нему продолжает расти. Бизнес видит в ИИ инструмент, позволяющий экономить на рабочей силе и получать большие результаты меньшими ресурсами. Пользователи делятся с ChatGPT личными данными и ответственностью при принятии решений.

Но алгоритмам не знакомы этика и мораль, и они совершают ошибки: от клеветы до оправдания насилия. Почему это не только техническая, но, прежде всего, этическая и правовая проблема, и как она касается бизнеса — в статье расскажет евангелист

Проблематичное «поведение» цифровых ИИ-продуктов

Искусственный интеллект всё глубже проникает в жизнь современных пользователей, но не всегда «ведёт» себя корректно.

Галлюцинирование

Пользователи по всему миру сталкиваются с тем, что ChatGPT придумывает им альтернативные биографии. Он перемешивает реальные и вымышленные факты. Например, норвежец и отец троих детей Арве Хьялмар Хольмен обнаружил, будто он убил двоих детей и был приговорён к 21 году тюрьмы. В Австралии мэр города Хепберн узнал, что в начале нулевых участвовал в крупном коррупционном скандале и отбыл срок в тюрьме за взяточничество.

По сути информация похожа на дипфейки, но, в отличие от них, её сгенерировал не злоумышленник, а сам искусственный интеллект. Пострадавшим пришлось идти в суд и добиваться удаления вымышленных событий с их участием из

Неэтичные советы

Дети из двух семей в Техасе общались с персонажами, которых сгенерировал для них

Это был не первый судебный процесс в истории Character. AI: ранее жительница Флориды обвинила

Утечки персональных данных

В марте 2023 года компания OpenAI сообщила о крупной утечке данных. Личные данные аккаунтов пользователей ChatGPT — последние четыре цифры и сроки действия банковских карт, имена и фамилии, адреса почты, — стали видны другим пользователям. OpenAI на сутки отключила

Дискриминация

Самый известный кейс — ещё в 2016 году компания Microsoft запустила экспериментального

В середине десятых годов корпорация Amazon разработала искусственный интеллект для отбора резюме, чтобы упростить найм. Вскоре оказалось, что система занижает рейтинг

Таким образом, интеграция ИИ в реальность может приносить неожиданные последствия: портить репутацию, создавать угрозу для безопасности, предлагать детям недетский контент. У ИИ нет морального компаса: он обучается на основе информации, которая уже существует в сети, и не всегда может отличить плохое от хорошего. Поэтому для защиты граждан государства и надгосударственные институты вводят правовые нормы, направленные на контроль генеративного ИИ.

Правовые нормы в области ИИ

Европейский Союз: AI Act и GDPR

В Евросоюзе формируется общая нормативная база для ИИ. Акт об искусственном интеллекте (AI Act) вводит

-

Неприемлемый риск — системы вроде социального скоринга населения, представляющие реальную угрозу для общества, запрещены.

-

Высокий риск — системы для медицины, транспорта, образования или найма персонала должны соответствовать строгим требованиям.

-

Ограниченный риск —

чат-боты и генеративные модели для широкой аудитории должны быть прозрачными: например, маркировать сгенерированный контент. -

Минимальный риск — остальные системы. При соблюдении общих законов им не нужно соответствовать специфическим требованиям.

Последние поправки Европарламента для провайдеров генеративного ИИ направлены на прозрачность и безопасность. Например, разработчики крупных моделей обязаны предотвращать генерацию вредоносного контента и раскрывать информацию о датасетах, использованных для обучения. Штрафы за несоблюдение AI Act обсуждаются — до 30 млн евро или 6% от глобального оборота компании.

Кроме того, в ЕС действует Общий регламент по защите данных (GDPR). Поскольку

Например, в 2023 году в Италии регулятор по защите данных временно запретил работу ChatGPT

США: рекомендации вместо единого закона

В Соединенных Штатах нет федерального закона, комплексно регулирующего ИИ, но есть рекомендации:

-

Комиссия по торговле (FTC) предупреждает, что будет пресекать обман потребителей и ложную рекламу на основе ИИ.

-

Национальный институт стандартов и технологий (NIST) выпустил Руководство по управлению рисками ИИ — подробный набор рекомендаций для компаний.

-

Ряд законов действует на уровне штатов. Например, в

Нью-Йорке нужно проводить аудит на отсутствие дискриминации для автоматизированных систем найма персонала. А Калифорния требует обязательной маркировки ботов в точках контакта с пользователями.

Также на ИИ распространяются общие законы: о защите потребителей, против дискриминации, о конфиденциальности.

Китай: жёсткий контроль и цензура

В Китае правительство стремится контролировать содержание сгенерированного контента и обеспечивать идеологическую лояльность

-

«Временные меры управления генеративным ИИ» с 2023 года требуют, чтобы

компании-разработчики получали лицензию от государства перед запускомИИ-сервиса . Алгоритмы обязаны генерировать корректную информацию и отказывать пользователям в запросах запрещённой тематики. Если ИИ сгенерирует запрещённый результат, провайдер должен удалить его и улучшить модель, чтобы предотвратить повторение. -

Верификация пользователей и маркировка. Компании должны идентифицировать пользователей (например, по паспорту или номеру телефона), чтобы при необходимости отследить и наказать за незаконное использование ИИ. Также требуется маркировать весь сгенерированный контент.

Нарушение правил в Китае ведёт к серьёзным последствиям: от крупных штрафов и требований доработать систему до блокировки сервиса и уголовной ответственности руководителей.

Россия

В настоящий момент можно говорить о ряде документов, которые были приняты в России в связи с внедрением, развитием и использованием искусственного интеллекта. В 2019 году был издан указ Президента о развитии ИИ — он регулирует специфику внедрения в разрезе экономики. Затем был принят ФЗ № 123 — о проведении технологического эксперимента с использованием ИИ в Москве. Он установил на территории Москвы пятилетний режим, согласно которому участники эксперимента получают мягкие условия регулирования: например, при обработке персональных данных или внедрении технических решений. Недавно, в июле 2025 года, ЦБ РФ выпустил информационное письмо о кодексе этики в сфере разработки и применения ИИ. Оно носит рекомендательный характер и адресовано участникам рынка финансовых услуг.

Поэтому нельзя говорить, что ИИ в России обделен вниманием законодательства. Со стороны государства к нему действует мягкий подход, позволяющий

Другие страны и международные организации

В Великобритании власти выпустили «Проиновационный подход к регулированию ИИ». А также поручили отраслевым регуляторам — например, по финансам, здравоохранению и транспорту, контролировать применение ИИ в своих сферах. Сейчас в Великобритании обсуждается введение обязательного кодекса для разработчиков ИИ, но пока он добровольный.

Канада включила регулирование ИИ в законопроект о цифровой приватности. Он предлагает обязать компании оценивать последствия деятельности своих

Во Франции действуют законы, косвенно касающиеся ИИ — например, обязанность раскрывать использование алгоритмов в госуслугах. Германия создала этический совет по ИИ. В странах Азии (Сингапур, Южная Корея, Япония) выпущены этические руководства для индустрии ИИ и запущены пилотные программы для тестирования.

Международные организации тоже стремятся установить общие правила:

-

ОЭСР (OECD) ещё в 2019 году приняла Принципы ИИ — не обязательные, но рекомендательные стандарты, призывающие к прозрачности, безопасности и уважению прав человека.

-

ЮНЕСКО в 2021 году одобрила Всеобщую рекомендации по этике ИИ — документ, который поддержали более 190 государств. Он содержит положения о надзоре за ИИ, оценке его влияния на общество, сохранении конфиденциальности данных, гендерном и культурном равенстве при разработке технологий.

-

Совет Европы готовит конвенцию по ИИ, которая может стать первым

международно-правовым договором, обязывающим государства соблюдать минимальные стандарты в этой области.

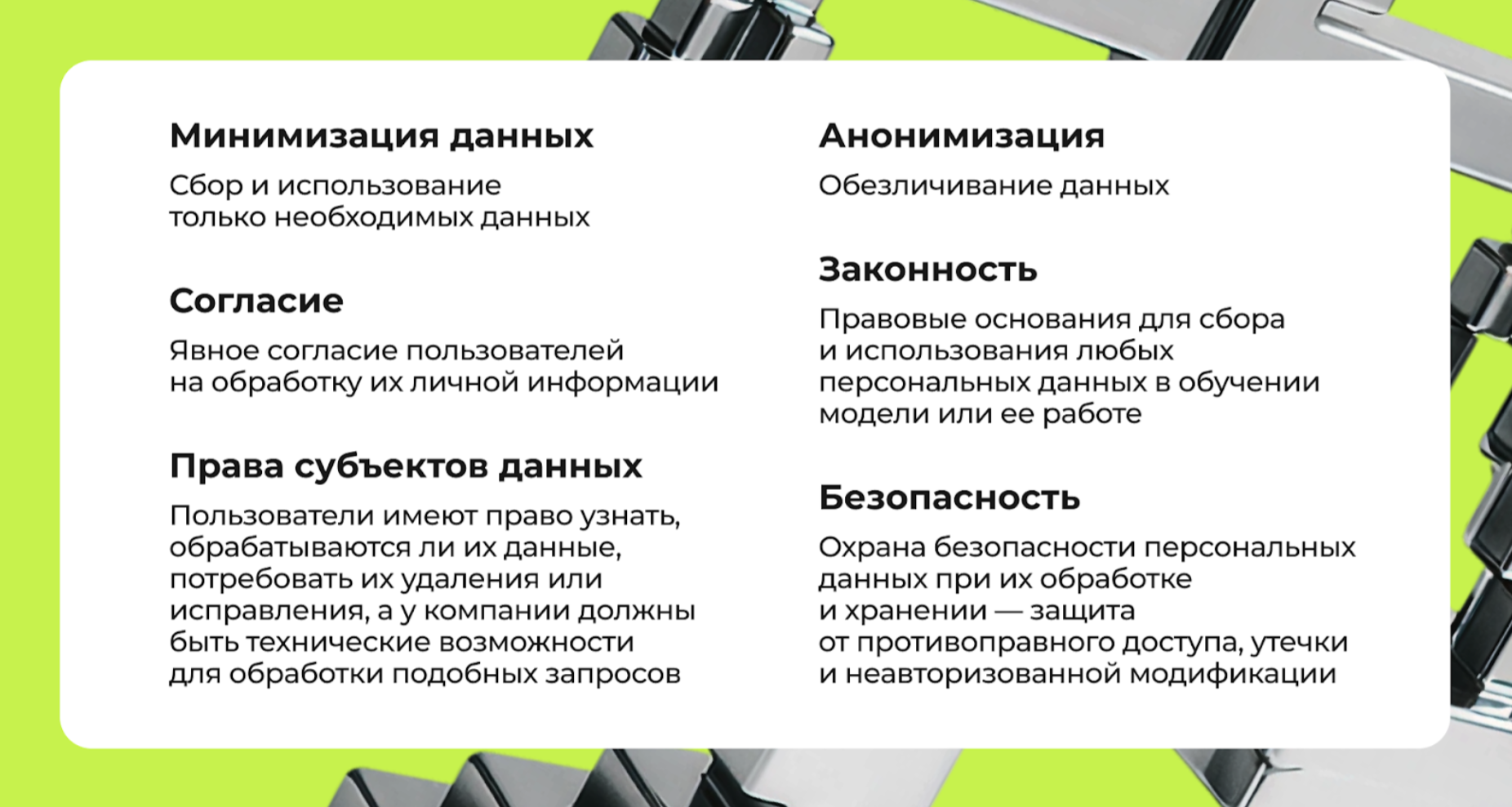

Защита персональных данных и ИИ

Персональные данные — отдельная зона риска при разработке ИИ. Ключевые требования законов о защите персональных данных, принятых во многих странах:

Несоблюдение требований законодательства несёт для компаний риски: штрафные санкции, блокировку или приостановку деятельности, уголовную или административную ответственность, гражданские иски и компенсацию ущерба, репутационные потери.

Что нужно учитывать компании, которая разрабатывает продукты с ИИ

Если компания предоставляет услуги на основе генеративного ИИ, ей нужно внедрить меры комплаенса:

Следить за законодательством. Передать юристам обязанности по соблюдению требований в законах и консультироваться с ними в рамках аудита проектов. Проходить проверки источников данных для обучения на качество и соответствие законодательству — например, очищать датасеты от незаконного контента или заведомо дискриминационных сведений.

Не использовать персональные данные незаконно. Датасеты для обучения

Соблюдать прозрачность по отношению к пользователям. Размечать сгенерированный контент и предупреждать пользователя, если с ним общается виртуальный ассистент.

Разработать внутреннюю политику по этике ИИ. Прописать принципы, которых придерживается компания — например, недопустимость предвзятости, уважение к приватности, приоритет безопасности. Создать процедуры по оценке новых функций на соответствие ценностям компании и общества. Наличие подобного кодекса демонстрирует ответственность в отношении ИИ для регуляторов и клиентов, а также может учитываться при расследовании инцидентов как фактор, смягчающий ответственность компании.

Оценивать риски и управлять ими. Заранее ввести ограничения: например, запрет на генерацию конкретных категорий контента,

Документировать разработки. Компании нужно вести документацию по

Продумать план Б. В случае, если продукт на основе ИИ «нарушит» законодательство, понадобятся технические возможности: например, удаление личных данных пользователя из датасета или предотвращение неэтичного контента в следующей версии продукта. Наличие плана сократит убытки и время простоя, если

Принимать меры кибербезопасности.

Оставить возможности для человеческого контроля и аудита. Например, если ИИ решает, выдать ли пользователю кредит, у оператора должна быть возможность вмешаться и проверить обоснованность его решения. Периодически можно привлекать экспертов для внешнего аудита алгоритмов.

Предотвращать утечки данных. Например, обучать персонал компании, для которой разработан продукт на основе ИИ, тому, что никакие чувствительные данные нельзя вводить в открытые

Искусственный интеллект ещё совсем новая технология. Риски, которые она несёт, уже понятны для общества, но как исключить их в реальности, неясно. Поэтому законодательство не до конца регулирует область ИИ, а регуляторы принимают скорее точечные решения.

Мнение редакции может не совпадать с мнением автора. Ваши статьи присылайте нам на 42@cossa.ru. А наши требования к ним — вот тут.